Keď dnes niečo nevieme, hneď googlime, alebo v poslednej dobe sa pýtame rôznych veľkých jazykových modelov, ChatGPT a podobných, ale hlavne táto druhá možnosť mi niekedy pripadá ako ekvivalent antických konzultácií s vešticou/oracle. (Ako preložiť oracle do slovenčiny? Veštica sa mi nepáči, takýto preklad ma svrbí, lebo nepasuje presne. Z veštice mám pocit, že si viac vymýšľa ako oracle, že oracle “vidí” viac ako veštica. Prorok sa mi páči ešte menej ako veštica, zaváňa mi náboženským kontextom, zatiaľčo oracle nie. Neviem. ChatGPT tiež nevie, ale neprizná to.)

Prečo podoba s oracle? Model odpovie (pravdepodobnostne odhadne) približne niečo, čo chceme počuť, pridá (hlavne v poslednej dobe) “hviezdičku “/ disclaimer /zadné dvierka, ktorými sa dá vykrútiť z ošemetnej situácie a nechá nás rozmýšľať o tom, ako veľmi sa môžeme na odpoveď, ktorú sme dostali, spoľahnúť.

To nie je málo a nie je to zle. Ale ani to nie je dosť a nie je to dobre.

Učím sa spolupracovať s Github Copilotom (o tom niekedy nabudúce), vypytujem sa GeePeeTee na všeličo, páči sa mi, hrať sa s River:

Ale málokedy dostanem presne to, čo chcem. Na inšpiráciu, “zhruba takéto niečo”, “first shitty draft” je to fajn, ale na niečo úplne konkrétne už nie až tak (možno s výnimkou toho Copilota, ak mu viem svoje požiadavky dosť dobre rozmeniť na drobné). Príklad: včera sme sa s Kubom pokúšali presvedčiť jeden text-to-image generátor (nie veľmi šíkovný, zadarmo), aby nám podľa našich zadaní vytvoril tímový portrét do jednej súťaže. Bola to zábava, ale výsledky úplne mimo.

Niektorým ľuďom sa zdá, že to je veľký problém. Napríklad nedávna aféra, keď model Gemini (bývalý Bard) od Google v záchvate dodatočne dodanej prílišnej korektnosti generoval rôznorodých ľudí aj v situáciách, v akých historicky zjavne neboli. Ale toto ani zďaleka nie je náš najväčší problém.

Áno, je trochu problém, keď model nakreslí čierneho amerického prezidenta z 18. storočia. Ale to je otázka času, kedy príde lepší model, ktorý už takéto chyby nebude robiť.

Je trochu väčší problém, keď sa zistí, že modely upravujú zadania od používateľov, napríklad k nim na pozadí pridávajú prívlastky a dodatočné inštrukcie, aby keď sa generujú ľudia, boli v skupine aj bieli, čierni, “zelení” a tak. Áno, rôznorodosť chceme, dokonca ešte aj “neférovú”, pretože tradične znevýhodňované skupiny treba zvýhodňovať, aby vôbec mali vyrovnané šance, ale asi nie práve takto, lebo “natvrdo naprogramovať zafarbovanie” (a používateľom o tom nepovedať) nastoľuje otázky, čo ešte je “zafarbené”? Aké iné (politické, spoločenské, zaujaté, ….) názory o tom, ako by mali odpovede vyzerať, sú nejakým spôsobom pridané, len o tom zatiaľ nevieme? Ale ešte ani toto nie je náš najväčší problém.

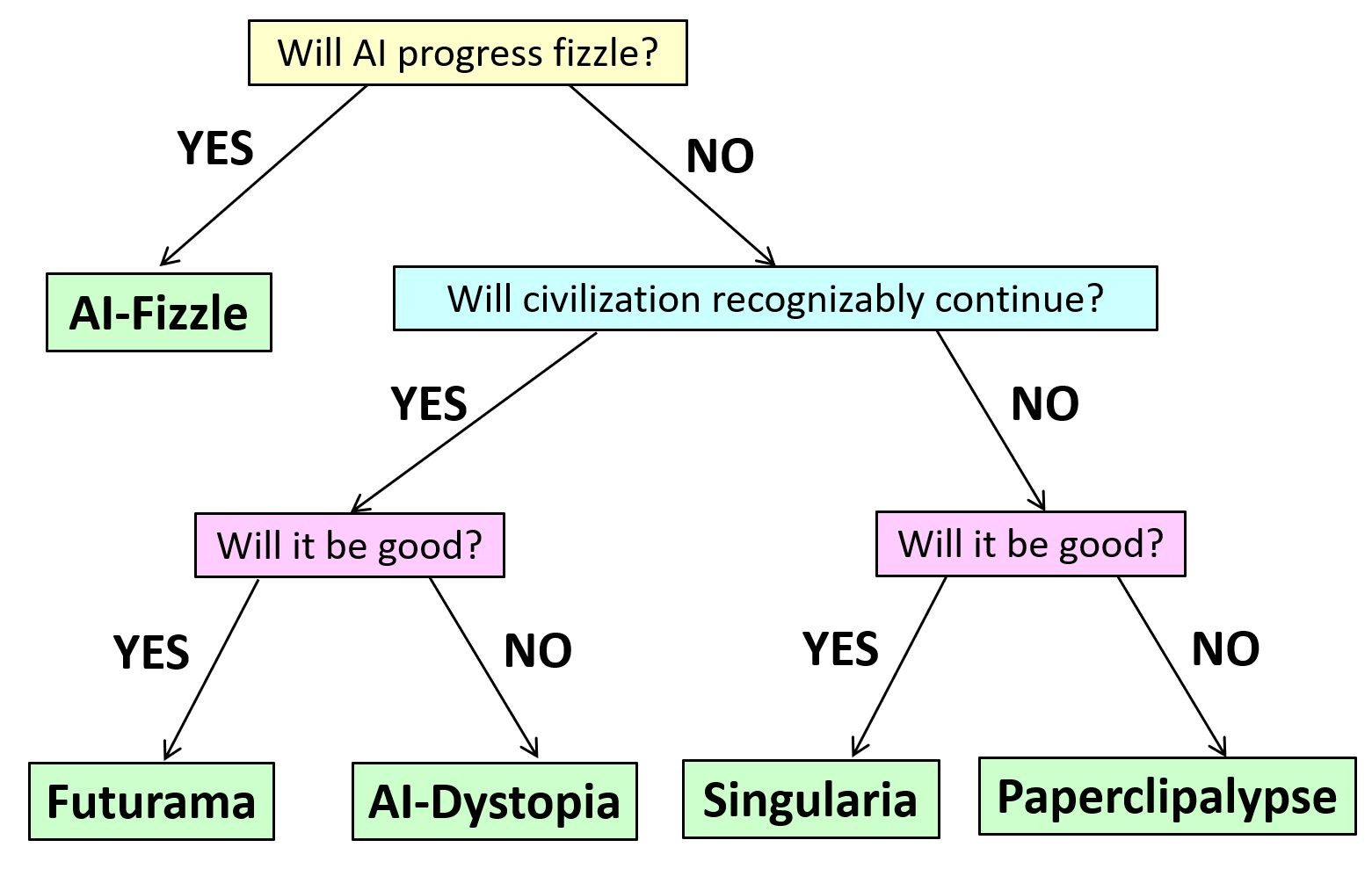

Diskutuje sa o AI alignment – ako docieliť, aby keď sa podarí vyvinúť AGI, “ozajstnú” umelú inteligenciu, aby sa nám (ľuďom) to nevymklo spod kontroly. Možných scénárov je typovo niekoľko, ale nie veľa z nich je pre ľudí priaznivých:

AI Fizzle – AGI sa nepodarí, budeme mať zaujímavé hračky, možno trochu lepšie ako teraz, ale nič svetoborné

Futurama – AGI sa podarí, všetko dobre dopadne, bude slúžiť ľuďom a zariadi nám úžasný život

AI Dystopia – AGI sa podarí, ale nedopadne to dobre, nebude slúžiť ľuďom, niečo typu Veľký brat

Singularia – AGI ako nový druh inteligentných bytostí nás vpodstate nahradí, alebo prinajlepšom bude nejako tolerovať

Paperclipalypse – AGI ako nový druh inteligentných bytostí nás vpodstate vyhladí v záujme nejakého cieľa, ktorému budeme prekážať (papierové spinky v názve na počesť myšlienkového experimentu, v ktorom je cieľom práve ich výroba a všetko ostatné musí ísť bokom).

AI alignment vôbec nie je jednoduchá úloha, ale ten veľký problém aktuálne je, že sme práve videli, ako niekto dá LLM sadu inštrukcií s dobrým úmyslom a výsledky sú iné, než predpokladali. A pritom modely len robia to, čo sa od nich chcelo. Krásne nám to v praxi ukazuje na tú papierospinkovú možnosť.

Keby sme takémuto (alebo kúsok inteligentnejšiemu) modelu dali za úlohu “vyrieš klimatické zmeny”, je celkom dobre možné, že model by (správne) usúdil, či už “len” alebo “aj” na základe toho, že to hovoria aj ľudia v dátach, na ktorých je trénovaný, že ľudia sú príčinou klimatických zmien a že na riešenie klimatických problémov, je teda potrebné ľudí odstrániť. Na to netreba nijaké zlé úmysly, hackerov a podobne, len logiku.